B'zの歌詞をPythonと機械学習で分析してみた 〜前処理編〜

1. 本Part概要

前Partでは「歌詞データの入手」と「前処理の必要性」について話しました。

本Partでは「実際にどのような前処理をしたか」について話していきます。

2. 前処理の概要

先に今回行った前処理の流れについて書かせて頂きます。

- mecabを用いて「名詞・動詞・形容詞」の抽出

- nltk, sklearnの英語のstopwordリストを用いて英語の不用語の削除

あくまでも上記は本データへの前処理の一例であって、絶対的なものではないです。

今回対象とする歌詞データは日本語・英語が混在しているちょっと特殊な文書データとなっております。

そこで、mecabは英単語を全て名詞と判定する性質を用いて、先にmecabで品詞を絞って、後に英語の前処理を施しました*1。

3. mecabを用いた前処理

3.1 mecabとは

簡単にいうと「日本語文を単語ごとに区切ってくれて、しかも品詞判定してくれる」便利なパッケージです。正確にはこれらの作業は「わかち書き」と呼ばれます。

インストールの仕方や簡単な使い方は以下のリンクを参考にしてください。

例えば、以下のような感じで単語のわかち書きができます。

#辞書指定はお好みで # tagger = MeCab.Tagger('') tagger = MeCab.Tagger('/usr/local/lib/mecab/dic/mecab-ipadic-neologd/') tagger.parse("")#バグ回避 result = tagger.parse("今日の天気は晴れである。It is sunny today.") print(result) 今日 名詞,副詞可能,*,*,*,*,今日,キョウ,キョー の 助詞,連体化,*,*,*,*,の,ノ,ノ 天気 名詞,一般,*,*,*,*,天気,テンキ,テンキ は 助詞,係助詞,*,*,*,*,は,ハ,ワ 晴れ 名詞,一般,*,*,*,*,晴れ,ハレ,ハレ で 助動詞,*,*,*,特殊・ダ,連用形,だ,デ,デ ある 助動詞,*,*,*,五段・ラ行アル,基本形,ある,アル,アル 。 記号,句点,*,*,*,*,。,。,。 It 名詞,一般,*,*,*,*,* is 名詞,一般,*,*,*,*,* sunny 名詞,一般,*,*,*,*,* today 名詞,一般,*,*,*,*,* . 名詞,サ変接続,*,*,*,*,* EOS

有能ですね。見てお分かりの通り、英語は名詞判定されてしまうのでご注意を。*2

3.2 名詞・動詞・形容詞のみの抽出

NLPでは「名詞・動詞・形容詞以外は大して意味を持っていないので削除」する方針で前処理を行うことが一般的に知られています。

そこで、曲ごとに必要な品詞の単語のみを取り出すコードを書きます*3。

詳細な文法等は以下のリンク等を参考にしてください。

詳細情報の取得 parse()の代わりにparseToNode()を使うと形態素の詳細情報が得られます。parseToNode()は先頭のノード(形態素情報)を返し、surfaceで表層形、featureで形態素情報を取得できます。両方とも文字列です。featureは , で区切られているのでsplit()などで分割して必要な情報を抽出します。

WindowsでMeCab Pythonを使う - 人工知能に関する断創録

def get_dokuritsugo_by_mecab(text): tagger = MeCab.Tagger('/usr/local/lib/mecab/dic/mecab-ipadic-neologd/') tagger.parse('') node = tagger.parseToNode(text) word_list = [] while node: pos = node.feature.split(",")[0] if pos in ["名詞", "動詞", "形容詞"]: # 対象とする品詞 word = node.surface word_list.append(word) node = node.next return " ".join(word_list) df_all["mecabで前処理"]=df_all["Lyric"].apply(lambda x : get_dokuritsugo_by_mecab(x))

さて、こちらで前処理された某曲の歌詞がこちらになります。 と曲のサンプルを載せたいのですが、ちょっと色々怖いので勘弁してください。*4

4. 英語の前処理

さて、次に英語の前処理を行います。

英語の前処理の目的は"it"や"is"といった意味のない単語を削除することです。

前述でも若干触れましたが、実はこのような単語は"stop words"と呼ばれ公開されています。

公開されているstop wordsリストで有名なものは以下の2つです。

from sklearn.feature_extraction import stop_words stop_words_sklearn=stop_words.ENGLISH_STOP_WORDS import nltk nltk.download('stopwords') stop_words_nltk = nltk.corpus.stopwords.words('english')

どっちがいいかということで比較を行うと、sklearnは318語、nltkは179単語となっており、nltkの方が基本的な単語のリストになっております。

今回は、力技で両方ともくっつけてstop wordリストを作成します。

stop_words_nltk.extend(stop_words_sklearn) stop_words_all=stop_words_nltk

リストにリストを足すときに、appendではうまくいかないことは想像がつくと思いますが、extendでうまくいきます。

(ちょっと躓いたのでシェア)

さらに実はなのですが、日本語のstop wordsリストを公開してくれているサイトも存在します。

slothlib_path = 'http://svn.sourceforge.jp/svnroot/slothlib/CSharp/Version1/SlothLib/NLP/Filter/StopWord/word/Japanese.txt' slothlib_file = urllib.request.urlopen(slothlib_path) slothlib_stopwords = [line.decode("utf-8").strip() for line in slothlib_file] slothlib_stopwords = [ss for ss in slothlib_stopwords if not ss==u'']

今回はこれを使うと「時間」や「彼女」などB'zっぽい単語も消えてしまうので、あえて使いません。

さて本題に戻り、stop wordsの削除をするコードを書きます。

上記のstop wordsの削除を行っても微妙な単語がいくつか残っていたので(本当はもっと上手くやりたいが)手動で削除。

import string import re add_words=["'",u"それ",u"てる",u"よう",u"こと",u"の",u"し",u"い",u"ん",u"さ",u"て",u"せ",u"れ"] stop_words_all.extend(add_words) def del_eng_stop_words(text): #!マークなども消したいので正規表現で空文字に置換 regex = re.compile('[' +re.escape(string.punctuation) + '0-9\\r\\t\\n]') sample = regex.sub("", text) #小文字にして、stop wordsに入っていなければリストに追加 words = [w.lower() for w in sample.split(" ") \ if not w.lower() in stop_words_all] words=' '.join(words) return words df_all["英語の削除"]=list(df_all["mecabで前処理"].apply(lambda x: del_eng_stop_words(x)))

5. 前処理の効果の確認

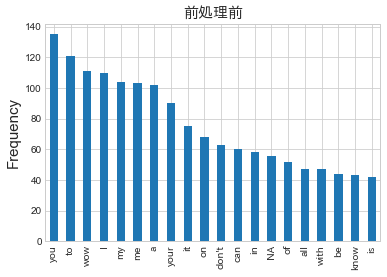

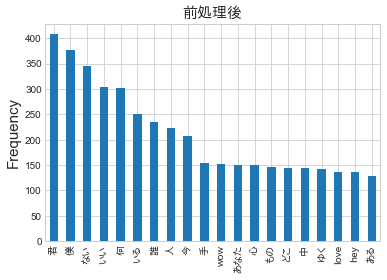

5.1 高頻出単語の比較

前処理の効果を見るために、出現頻度が高い単語の比較を行います*5

上図を見ると前処理後は「君」「僕」「love」といったそれっぽい単語が高頻度で出現していることが見てとれます。

このことからいい感じに前処理できているということができます。

5.2 Word Cloudを用いた可視化

データ入手編でもお話ししたWord Cloudで再度可視化します。

前Partで作成した図に比べ凄くそれっぽいカッコイイ図が生成されました。

個人的には満足なのでひとまず前処理はこちらで終了です。

6. 最後に

本Partでは諸々の前処理について書きました。

次Partでは、いよいよ「機械学習を用いた分析〜TF-IDF編〜」を書いていきます。